Wie schlau ist künstliche Intelligenz?

Konstantin Mascher im Gespräch mit Thilo Stadelmann

Konstantin Mascher: Es ist ein regelrechter Hype um das Thema KI, gerade in Form von ChatGPT, entstanden. Was ist da auf einmal los?

Thilo Stadelmann: Es ist nützlich geworden. Wir können damit Dinge machen, von denen wir seit 70 Jahren träumen. Im letzten Jahr haben die Tools eine Qualität erreicht, mit der man Daten nicht nur analysieren, sondern Bilder und Texte generieren kann. Wer das nutzt, merkt nach zwei Minuten, dass die Qualität nicht über jeden Zweifel erhaben ist, aber doch irgendwie brauchbar.

Was ist Künstliche Intelligenz eigentlich? Wie kann man das definieren?

Das Fachgebiet „Künstliche Intelligenz“ hat in den 1950er Jahren diesen verheißungsvollen Namen bekommen, weil man damit leichter an Geld zu kommen hoffte. Dabei geht es um das Lösen komplexer Probleme mithilfe des Computers. Das ist nicht das gleiche wie Intelligenz. KI-Entwickler bauen Werkzeuge für jeweils bestimmte Fragestellungen, die der Mensch mit seiner einen Intelligenz angeht. Schachspielen löst KI heute noch mit anderen Werkzeugen als etwa das Schreiben von Texten. Es gibt nicht die eine Künstliche Intelligenz, auch wenn es heute chic ist, so zu reden.

Es ist nichts Neues und trotzdem etwas Neues. Kann man diese Entwicklung mit irgendwas in der Menschheitsgeschichte vergleichen?

Technologisch ist es eine Fortführung. Die Methoden von heute basieren auf der Idee künstlicher neuronaler Netze und sind in ihrem Aufbau von biologischen Nervenzellen inspiriert. Viele einfache Einheiten werden miteinander vernetzt. Diese Idee hat man seit den 40er Jahren auf ein mathematisches Modell übertragen, damit arbeitet man heute noch.

Was seit Ende letzten Jahres zu einer, sagen wir ruhig Zeitenwende geführt hat, ist der Nutzen. Als Anfang der 90er Jahre das World Wide Web aufkam, war es grottenhässlich. Keine gute Auflösung, blinkende Schriften in rosa und gelb… Aber es hat die Art, wie wir Computer bedienen und wie wir kommunizieren, wie wir Medien konsumieren, Business betreiben usw. grundlegend geändert. Mit der Künstlichen Intelligenz sind wir an einem ähnlichen Punkt. Es gab keinen technologischen Sprung, sondern die Grenze zur Nutzbarkeit wurde überschritten.

Was ist die Stärke von KI?

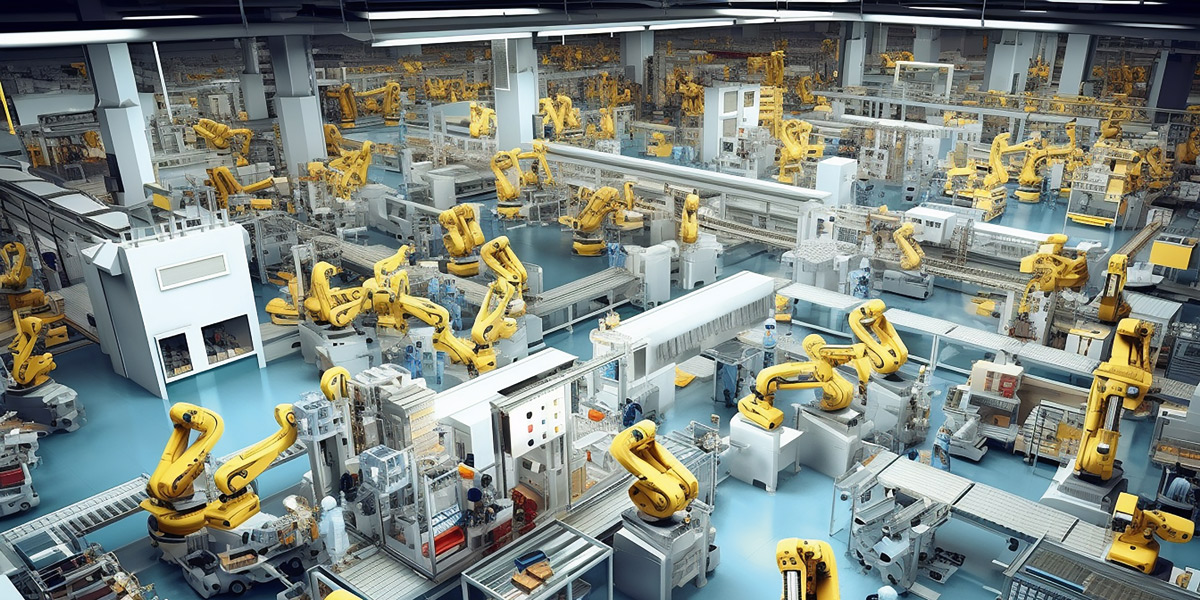

KI ist prinzipiell gut darin, repetitiv Sachen zu automatisieren. Solange die Aufgabe repetitiv ist, kennt KI bei der Komplexität keine Grenze.

Mithilfe von KI kann man ganz viele Daten verarbeiten und darin kleine, feine Muster finden, die uns entgehen würden, weil wir das nicht alles im Blick haben könnten. Unter den Millionen Milliarden Möglichkeiten, wie Moleküle verschaltet werden könnten, kann die KI die paar 1000 auswählen, die z. B. für ein bestimmtes Medikament gute Kandidaten wären. Diese paar 1000 können im Labor getestet werden und dann wird gebaut, was wirklich funktioniert.

Viele Arbeitsbereiche wird KI durch verstärkte Automatisierung erleichtern. Was ist mit steigender Arbeitslosigkeit?

Auf der einen Seite sehnen wir uns nach Arbeitserleichterung, aber wenn sie in Sicht ist, bekommen wir Angst. Manchmal kann man lesen vom Leid der Menschen in Callcentern, die sich stundenlang Pöbeleien von frustrierten Kunden anhören müssen. Mit dem Tenor, arme Menschen, was für ein Job! In der gleichen Zeitung findet sich wenig später ein Artikel, dass das erste Telekomunternehmen 50.000 Callcenter-Jobs durch KI ersetzt – in den nächsten zehn Jahren, was für eine Katastrophe! Aber will ich sinnstiftende Tätigkeiten oder will ich mich darüber aufregen, dass Bullshitjobs durch KI-Systeme nicht mehr notwendig sind?

Hältst du es für möglich, dass Künstliche Intelligenz beginnt, selbst eine bessere künstliche Intelligenz zu entwickeln, wie man es oft hört?

Da ist vieles Science-Fiction. KI lernt beispielsweise nicht ständig dazu und es ist auch nicht absehbar, wie viele andere notwendige Zutaten es für solch ein Szenario geben sollte. Es ist ein grundlegender Unterschied, ob ich als Chiphersteller KI einsetze, um die Leiterbahnen auf meinem Chip zu optimieren. Oder ob ich ein System auf sich selber anwende und sage, verbessere dich doch mal. Leute, die anderes in naher Zukunft sehen, haben die Überzeugung, dass das gehen muss, weil Science-Fiction es ja vormacht. Sie haben aber keine wissenschaftlichen Argumente, das ist Glaubenssache.

Missbrauch im Zusammenhang mit KI nimmt rapide zu. Man denke an das Deepfake-Video vom ukrainischen Präsidenten Selenski im Jahr 2022, in dem er seine Armee auffordert, den Kampf gegen Russland aufzugeben. Müssen wir mit einer Flut an Desinformation rechnen?

Nüchtern betrachtet wird sich diese Problematik sicherlich verschärfen. Man kann mit diesen Tools in kurzer Zeit mit wenig eigenen Skills perfekt daherkommenden Content schaffen. Leute mit krimineller Energie, die Böses tun wollen, werden das einfacher tun können. Aber das ist nicht neu und dem stehen wir nicht hilflos gegenüber. KI kann auch dabei helfen, die Desinformation rauszufiltern, bevor sie in irgendeinem Feed auftaucht. Desinformation und Manipulation werden uns als Gesellschaft beschäftigen. Das ist eine ernstzunehmende Herausforderung. Mir ist wichtig, dass wir damit umgehen können. Wir müssen nicht einfach die Waffen strecken.

Mal ganz platt gefragt: Gibt es eigentlich eine ethisch gute KI?

Es gibt ethisch gute Entscheidungen von Menschen und ethisch schlechte oder fragwürdige. Ein mächtiges Werkzeug wie KI kann man für beides einsetzen. Es kann unbeabsichtigte Nebeneffekte geben, die nicht die Folge schlechter Absichten sind, sondern fehlerhafter Technologie. Da kann und muss man schon im Design auf ethische Aspekte achten. Das Feld Datenethik hat in den letzten fünf Jahren stark zugenommen, es fokussiert hauptsächlich auf Fairness. Wenn nicht mehr ein menschliches Gegenüber, sondern ein System anhand von in Algorithmen gegossenen Regeln entscheidet, ist es wichtig, dass das System so angelegt ist, dass auch Menschen eine Chance haben, die nicht dem statistischen Durchschnitt entsprechen.

Wir haben dazu jetzt das erste Mal ein Angebot für unsere Studenten. Was ist überhaupt Fairness? Das hängt sehr vom Fall ab und kann in einer anderen Anwendung ganz anders sein. Die Studierenden lernen, dass ein System, das – ohne auf Fairness zu achten – entwickelt wurde, tendenziell zu einem unfairen Ergebnis führt.

Wenn ich bei Chat-GPT eine Frage eingebe, bekomme ich eine Antwort, ohne dessen Wertesystem zu kennen. Wäre das im Sinne der Transparenz nicht wichtig?

Ich habe Zweifel, dass es helfen würde, wenn Anbieter ihre Werte aufschrieben. KI-Systeme sind in einen wirtschaftlichen Kontext eingebunden und von Wahrhaftigkeit sind wir in unserem Wirtschaften doch weit entfernt. Unsere Wirtschaft basiert auf Messages, die proklamiert werden, weil es die richtigen Messages sind, nicht, weil man dahintersteht. Menschen wollen so oft das Gute und sind in der Praxis so weit davon entfernt. Ich glaube nicht, dass es hilft, wenn man bei einem KI-System aufschreibt, was man gerne hätte, dass es tut, aber niemanden, der das überprüfen kann. Vielleicht wäre es fairer, die Kriterien, die es optimiert, zu benennen, und nicht nach Idealwerten zu fragen.

Wie können wir verhindern, dass KI-Systeme die gegebenen Ziele zwar erfüllen, aber dabei zweifelhafte Wege einschlagen, z. B. zur Lösung der Klimafrage die Eliminierung des Menschen vorschlagen?

KI-Systeme sind in einzelnen Aspekten dem Menschen haushoch überlegen. Die neueren Systeme sollen aus menschlichem Feedback lernen. Large-Language-Modelle wie die Vorläufer von ChatGPT haben gelernt, mit Sprache umzugehen, indem sie nach dem nächsten wahrscheinlich besten Wort im Kontext suchen. Frühere Versuche mit Chatbots mussten nach wenigen Tagen vom Netz genommen werden, weil sie unflätig wurden, Unwahrheiten äußerten, Leute beleidigten usw. Bei ChatGPT wurden dem System in einem weiteren Schritt relativ wenige Fragen gestellt, zu denen es nicht nur eine, sondern mehrere mögliche Antworten kreierte. Dann sollten Menschen sagen, welche dieser Antworten sie präferieren würden. Zu lange oder einsilbige Antworten fielen raus. Beleidigende Sachen fielen raus. Außerdem gab es einen kleinen Katalog mit Regeln. Das System soll nicht diffamieren, es soll nicht irgendeine bestimmte Minderheitenmeinung zur Wahrheit erheben usw. Und genau das passiert. Wenn ich ChatGPT nach etwas frage, was allgemein als Verschwörungstheorie klassifiziert wird, versieht es das mit ganz vielen Disclaimern. Diese Systeme müssen letztendlich immer auf den Menschen referenziert bleiben und ihn nicht einfach als eine von vielen Variablen im Kosmos betrachten.

Sind wir auf KI angewiesen, um mit KI umgehen zu können?

KI Systeme helfen, komplexe Sachen in den Griff zu bekommen. Wir stehen noch ganz am Anfang, auch mit der Frage nach der Rolle des Staates. Es ist richtig, jetzt zur Regulierung aufzurufen. Wir haben ja auch Regeln für den Straßenverkehr erlassen, auch wenn sich jeder mal über das Zone-30-Schild aufregt. So was brauchen wir auch bei KI.

Die KI-Szene spaltet sich in zwei Positionen. Die hoffnungsvolle erwartet ein neues Zeitalter, in dem Fragen wie Krankheiten oder der Klimawandel mit KI gelöst werden. Wie siehst du diese Zukunft?

Ich bin prinzipiell optimistisch. Da ist vieles möglich, z. B. dass wir Medikamente für Einzelfälle entwickeln können oder so was Komplexes wie den Klimawandel oder die Energiewende in den Griff kriegen. Large-Scale-Systeme, die sich der Steuerung qua ihrer Komplexität entziehen, kann man mit KI regeln. Die Community ist sich soweit einig, dass sie es auf jeden Fall für lohnend hält.

Eine Reihe Experten, u. a. Sam Altman, der Chef hinter ChatGTP, vergleichen die Risiken von KI mit der von Pandemien oder einem Nuklearkrieg. Das sind ja keine Hobbytheologen oder Endzeitpropheten. Wie können wir diese Sorge einordnen?

Das sind ernst zu nehmende Leute, deren Besorgnis aber letztlich nicht geteilt werden muss. Ich habe einen dezidiert anderen Standpunkt dazu. Diese Menschen argumentieren nicht von ihrer technischen Expertise aus, sondern aus dem, was sie für wahr halten. Im Silicon Valley ist die Ideologie des Longtermism allgegenwärtig. Das ist die eigentlich gut klingende Idee, dass viele zukünftige Leben eine höhere Priorität haben sollten als wenige aktuelle. Wenn wir noch 1 Milliarde Jahre leben und das ganze Universum besiedeln, sind das in Zukunft unglaublich viel mehr Leben als heute. Verglichen damit sind z. B. die Katastrophen des 20. Jahrhunderts nicht so gravierend, weil die Kosten-Nutzen-Abwägung langfristig positiv ausfällt. Ihr Weltbild bringt diese Leute dazu, etwas zu postulieren, was nicht absehbar ist, was sie aber in ferner Zukunft für möglich halten, weil sie es glauben. Dem kann man einen anderen Glauben entgegensetzen.

Das ist sehr hilfreich. Ich möchte auf eine Ursehnsucht des Menschen zu sprechen kommen. Wir wollen autonom sein und gleichzeitig etwas haben, das über uns steht und in dessen Hand wir freiwillig unsere Entscheidungen abgeben. Wie siehst du das? Was treibt dich an, weiter zu forschen?

Ich finde es interessant, dass gerade die Leute an dieser Stelle von Gott reden, die ansonsten furchtbar wenig mit seiner Existenz anfangen können. Der Urantrieb, etwas zu machen, was vorher noch nicht gemacht worden ist, ist dem Menschen zutiefst zu eigen und findet viele verschiedene Ausdrucksformen, für den einen an der Staffelei, für den anderen bei der Konstruktion von Brücken. Für viele, die wirklich gerne forschen, ist der altruistische Zweck nachgelagert, sie stellen Fragen und suchen nach Lösungen.

Ich bin Christ. Für mich stellt sich das relativ simpel dar. Da ich von Gott geschaffen bin, habe ich von meinem Daddy etwas mitbekommen, was ich mit elterlichem Segen weiter ausbauen kann, nämlich auch schöpferisch tätig zu sein. Das ist mein Antrieb, kombiniert mit dem Wunsch, die Welt zum Guten zu beeinflussen. Ich halte das mit dieser Technologie für möglich. Das Problem sehe ich eher bei unserem Autonomiestreben als bei der KI.

Manche Christen sind beunruhigt von der rasanten Entwicklung der KI, andere eher resignativ. Was ist denn deine Überzeugung und Hoffnung?

Die griechische Herkunft des Wortes Technologie finde ich hilfreich. Der Wortstamm techné steht für Kunst und Handwerk und der zweite Teil logos für Wort von Gott. Technologie bedeutet, die Kunst und das Handwerk, Gottes Worte anzuwenden, um die Probleme der Welt anzugehen. Technologie ist uns gegeben, um damit unserem Auftrag nachzukommen, den Planeten gut zu verwalten. Sie wurde uns gegeben, um damit Gutes zu tun.

Es hilft, wenn man sich anschaut, wie man mit unbegründeten Ängsten umgeht. Kein Gebot wird in der Bibel so oft wiederholt wie Fürchte dich nicht. Das hat einen praktischen Grund. Wir sind nicht unser bestes Selbst, wenn wir verängstigt sind. Gerade im Bereich KI sind ganz viele Ängste unbegründet. Wir reden von künstlicher Intelligenz, dabei geht es darum, komplexe Probleme zu lösen. Wir reden von Machine Learning, obwohl keine Maschine dazulernt. Wir vermenschlichen Technologie und dann treten die großen Tech-CEOs mit ihrem Weltbild auf und vermischen Science-Fiction mit Wissenschaft. Wenn wir nüchtern bleiben, lösen sich ganz viele Ängste auf. Was bleibt, sind Herausforderungen, mit denen man umgehen, und Chancen, die man auch erst mal ergreifen muss. Wir können auf eine wirklich spannende Zukunft schauen.

So ist es! Vielen Dank für das Gespräch.

Prof. Dr. Thilo Stadelmann ist Wissenschaftler, Dozent, Redner, Consultant, Networker, Projektleiter, Reviewer, Mentor, Leiter, Vater, Glaubender. Er leitet das Centre for Artificial Intelligence an der ZHAW Zürcher Hochschule für Angewandte Wissenschaften.

Hier geht es direkt zu unserem Podcast feinhörig mit dem ungekürzten Gespräch.